2024 诺贝尔物理学、化学奖都颁给 AI 领域,这会是未来主流吗?物理学和化学没有颠覆性的发现了吗?

未来已来?2024诺贝尔奖揭示跨学科的AI时代

“我获得了诺贝尔物理学奖?这是不是一个恶作剧电话呢?”

当图灵奖得主、AI教父杰弗里·辛顿(Geoffrey E. Hinton)凌晨两点接到一个来自瑞典的陌生来电告知获奖喜讯时,他正在美国加州远郊区一个没互联网、电话信号也很差的廉价旅馆。

2024年诺贝尔物理学奖于10月8日下午5:45分揭晓,今年颁给了普林斯顿大学的约翰·霍普菲尔德(John J. Hopfield)和加拿大多伦多大学的杰弗里·辛顿,以表彰他们利用人工神经网络进行机器学习的基础发现和发明。

瑞典皇家科学院的话音未落,全球哗然。诺贝尔奖官方账号竟然被全球网友给冲爆了,“计算机AI能算物理吗?”“物理学奖怎么颁给计算机科学了?”“辛顿拿了图灵奖为什么又来拿物理学奖?”……连获奖者辛顿本人对此也很意外:“I had no idea I’d even be nominated for the Nobel Prize in Physics, I was extremely surprised.”

谁能想到,第二天的诺贝尔化学奖,官方再次垂青AI领域。围观群众甚至调侃诺贝尔文学奖是不是颁给ChatGPT。

这届诺贝尔奖,已经被AI渗透。然而,细究起来,也不算意外,因为AI的浪潮正汹涌而来。

奠基人工智能:神经网络与机器学习的革新

在人工智能的澎湃滚滚进程中,两位诺奖得主运用物理学工具构建了多种方法,为今天强大的机器学习包括ChatGPT在内的语言大模型铺平了道路。

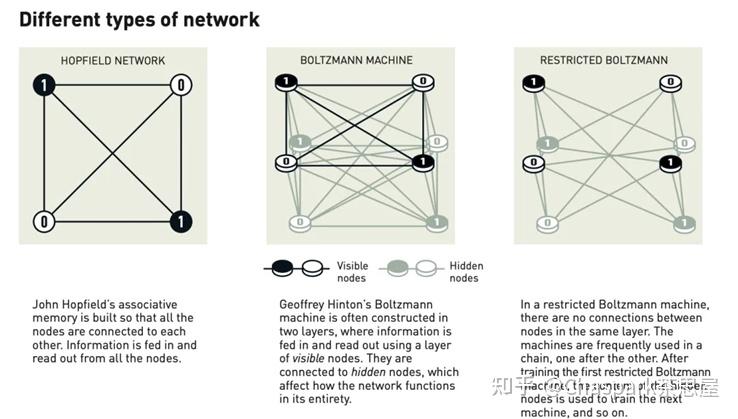

霍普菲尔德借鉴物理学中自旋系统和能量态分布概念,将复杂的神经网络问题转化为能量最小化问题发明了Hopfield网络模型。这是一种递归神经网络,具有对称连接和能量函数,用于存储和检索模式。人脑就像个巨大的记忆库,能够通过一点线索回想起完整的记忆。Hopfield网络模拟了这种记忆过程的神经网络模型。

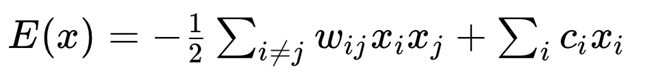

霍普菲尔德网络的能量函数通常表示为:

其中,

表示神经元的状态,

表示神经元i和j之间的连接权重,

表示神经元i的偏置 。

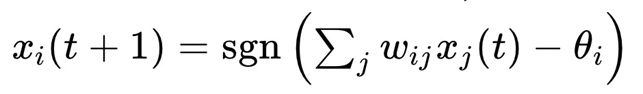

当Hopfield网络被输入扭曲或不完整的图像时,它会有条不紊地处理节点并更新神经元的值(异步更新)为:

其中,t表示时间步,sgn函数是符号函数,

是神经元i的阈值

Hopfield神经网络模型就像是一把钥匙,打开了人工智能和神经网络发展的大门,它揭示了神经元系统如何相互作用以产生稳定记忆,以及如何根据部分信息重建完整记忆。

辛顿则以霍普菲尔德网络为基础,引入随机性,于1983年创建了一个新网络——玻尔兹曼机(Boltzmann machine),这种网络使用统计物理学中的工具,可以学习识别给定类型数据中的特征元素,神经元状态以一定概率更新,遵循玻尔兹曼分布。

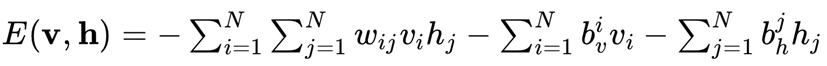

包含n个神经元(包括可见单元和隐藏单元)的波尔兹曼机的能量函数表达式为:

玻尔兹曼机不仅可用于图像分类,还能为其所训练的模式类型创建新的例子。后来辛顿带领团队在这项研发的基础上,帮助启动了当前机器学习的爆炸性发展,也就是全球应用广泛的人工智能深度学习。

1986年,辛顿与Rumelhart、Williams在《Nature》发表了误差反向传播算法。该算法让神经网络经历第一波寒冬后,重新走向人工智能的舞台,并应用于神经网络。

尽管计算机尚未具备人类的深思熟虑能力,但它们可以模拟记忆和学习等功能。这一切的实现,得益于两位科学家的卓越贡献。他们利用物理学的基本概念和方法,开发了利用神经网络结构处理信息的技术。其研究几乎构成了从计算机视觉系统到大语言模型的基础,促使全球迎来了新一轮生成式AI革命。

几十年来,辛顿和霍普菲尔德的研究不断获得认可。正如诺贝尔物理学委员会主席艾伦·穆恩斯的评价:他们的工作“已经带来了巨大的效益”。如今风靡全球的语言大模型ChatGPT,也都基于辛顿和霍普菲尔德的研究成果。

生命的前沿:2024化学诺奖也垂青AI

生命的多样性展示了蛋白质作为化学工具的惊人能力,2024年诺贝尔化学奖的主题正是“生命中的蛋白质”。获奖者之一大卫·贝克(David Baker)通过AI设计,构建了大量全新的蛋白质,成功实现了几乎不可能的任务。同时,来自谷歌DeepMind的德米斯·哈萨比斯(Demis Hassabis)和约翰·詹珀(John M. Jumper)开发的AI模型——AlphaFold,预测了研究人员迄今为止识别的所有2亿种蛋白质的结构。

蛋白质作为支撑生命活动的基础,由20种氨基酸串联形成独特的三维结构。长期以来,科研人员为确定蛋白质的结构需要依赖复杂的实验方法。蛋白质结晶尤其困难,特别是对于无法结晶的膜蛋白,研究常常需要借助昂贵的电子显微镜或X射线晶体分析仪,耗费数月甚至数年。

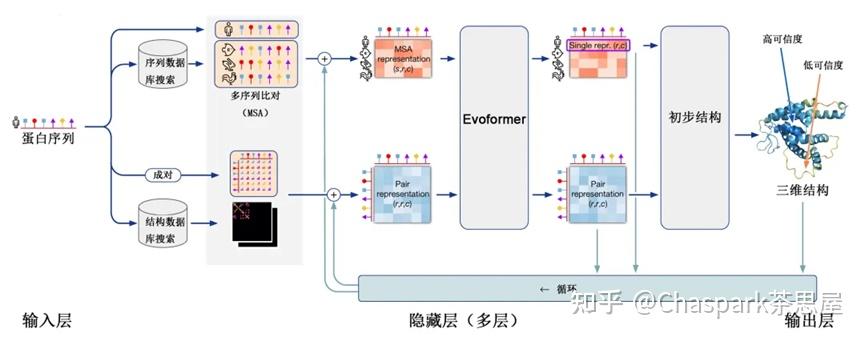

AlphaFold2的出现打破了这种局限,它能从蛋白质的氨基酸序列预测其3D结构,精度达到了原子级水平,被认为解决了困扰科学界长达50年的蛋白质折叠难题,极大推进了人类对基本生物过程的理解,并为药物开发以及新材料创造开辟了全新途径。

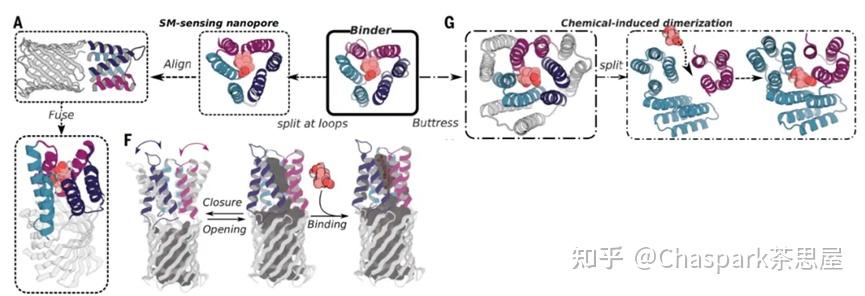

AI技术的应用,使科学家能够更加快速、准确地预测蛋白质结构,这对于生物医学研究和药物设计等领域具有深远影响。大卫·贝克教授利用AI设计了一种带有中心空腔的、小分子量的假环肽。这种基于形状互补的蛋白质设计方法为多种生物感兴趣的分子生成强大的、配体响应的门控通道和生物传感器。

他的研究重点是蛋白质结构的预测和设计、蛋白质折叠机制、蛋白质-蛋白质相互作用、蛋白质-核苷酸相互作用以及蛋白质-配体相互作用。而凭借在蛋白质折叠方面的成果,大卫·贝克还曾获得2008年萨克勒国际生物物理学奖、2021年生命科学突破奖、2021年威利奖。

目前科学家所使用的所有蛋白质都是自然界进化了数十亿年的产物,而AI技术的广泛应用加速了科学家蛋白质结构的研究,尤其是生物医学研究和药物设计等领域具有重大意义。他们的发现展示了AI在化学研究中的革命性潜力,人类有可能通过AI的帮助触摸到合成生命物质的前沿。

多学科融合:推动科学研究的边界突破

连续两天的诺奖都颁给了与AI相关的研究,引发无数人质疑:科学研究的范式已经被AI彻底改变了吗?我们从此不再需要人类科学家了吗?还有物理学家讽刺道:“诺贝尔物理学奖在抢图灵奖饭碗”。

那么,霍普菲尔德和辛顿与物理学到底有何关联?Hopfield网络和玻尔兹曼机都基于能量模型。Hopfield网络借鉴了材料物理学中原子自旋的特性——这使得原子像微小的磁铁一样相互作用。其网络的结构与物理学中自旋系统的能量非常相似,通过优化节点之间的连接值,网络能够将图像保存在低能量状态。两位科学家使用的核心方法是基于统计力学的能量函数,通过这种方式,他们解决了模式识别和数据分类的问题。Hopfield网络通过能量函数寻找最稳定的存储模式,而玻尔兹曼机则依靠调整节点权重来学习数据分布。这些研究不仅为联想记忆奠定了理论基础,在计算机视觉等领域也有广泛应用。而辛顿进一步扩展了这些理论,使得深度学习在生成式AI中发挥了重要作用。

有趣的是,诺贝尔奖委员会还发了一条推文解释:“你是否知道,机器学习模型其实基于物理方程来的?”

与诺贝尔物理学奖颁发给研究人工神经网络和深度学习的科学家相比,诺贝尔化学奖的三位得主在奖项揭晓前已呼声极高,授予蛋白质计算设计的先驱者以及与人工智能结合的研究可谓是众望所归。

可以说,这些研究定义了一个新的科学范式:从现实问题出发,将其转化为AI可以处理的数据输入,通过深度学习网络得到解决方案。这一技术不仅在生物、化学和物理等领域中发挥作用,应用的广度取决于如何将现实问题有效抽象成AI可以学习和处理的形式,以及现实世界是否存在足够多的真实数据来训练深度学习网络。

AI变革科学发现的历程,已经开始。

参考资料:

https://www.nobelprize.org/

http://www.cs.utoronto.ca/~hinton/absps/naturebp.pdf

https://www.cs.toronto.edu/~hinton/csc321/readings/boltz321.pdf

https://www.cs.toronto.edu/~fritz/absps/ncfast.pdf

https://www.msn.com/en-us/news/technology/nobel-prize-in-chemistry-honors-3-scientists-who-used-ai-to-design-proteins-life-s-building-blocks/ar-AA1rWWZE?ocid=BingNewsSerp

新公网安备 65010402001845号

新公网安备 65010402001845号